Der Algorithmus einer Suchmaschine ist eine Reihe von Regeln, die eine Suchmaschine verwendet, um Listen als Antwort auf eine Suchanfrage zu erstellen und wird manchmal auch als die „secret sauce“ bezeichnet. Suchmaschinen schicken in regelmäßigen Abständen einen Crawler durch das Netz, um alle Webseiten und deren Inhalte zu indexieren.

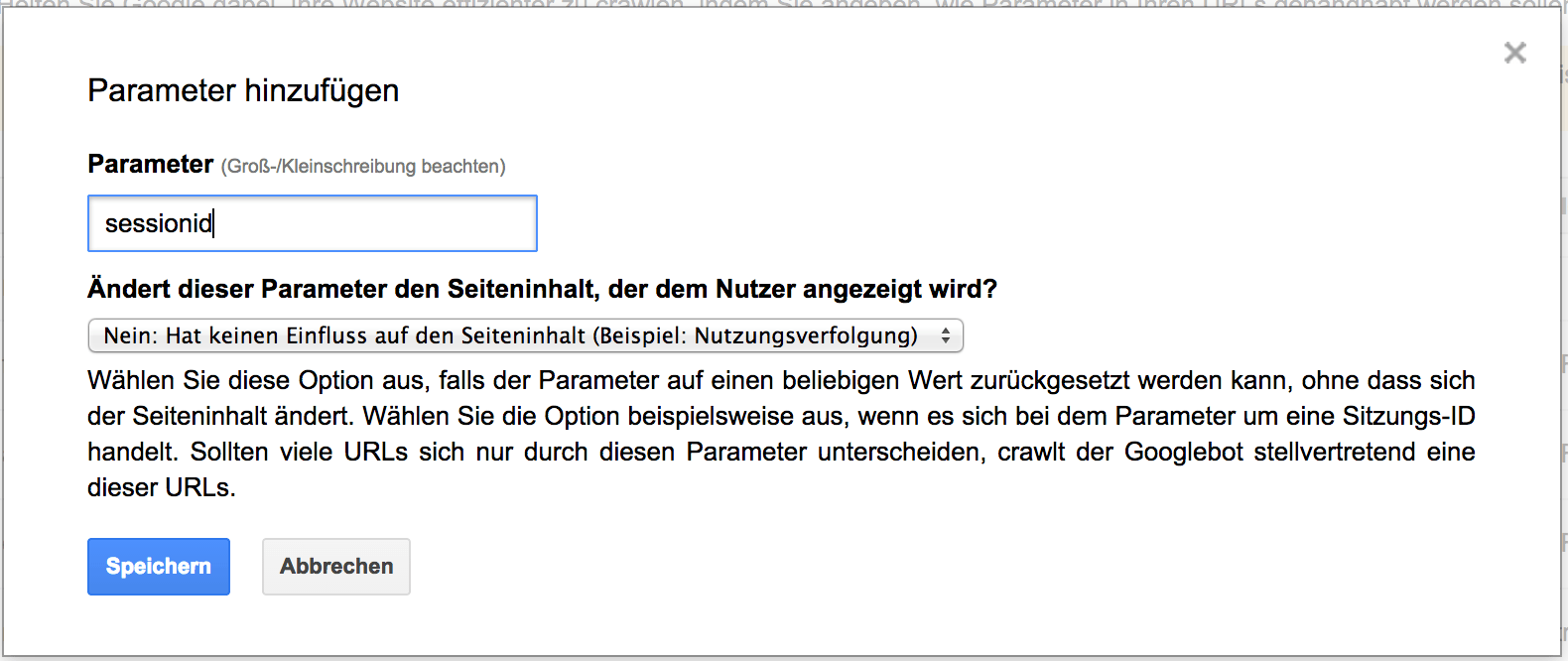

Der erste Schritt besteht darin, herauszufinden, welche Seiten im Internet existieren. Da es kein zentrales Verzeichnis aller Webseiten gibt, muss jede Suchmaschine ständig nach neuen Seiten suchen und sie in die Liste der bekannten Seiten aufnehmen. Einige Seiten sind bekannt, weil die Suchmaschine sie schon einmal besucht hat. Andere Seiten werden entdeckt, wenn der Crawler einem Link von einer bekannten Seite zu einer neuen Seite folgt. Wieder andere Seiten werden entdeckt, wenn der Eigentümer einer Website eine Liste von Seiten (eine Sitemap) zum Crawlen einreicht. Diesen Vorgang bezeichnet man als Crawling.

Sobald eine Suchmaschine eine neue Seiten-URL entdeckt hat, wird die Seite besucht oder gecrawlt, um herauszufinden, was sich auf der Seite befindet. Moderne Suchmaschinen rendern die Seite sogar und analysieren anschließend sowohl den Text- und Nicht-Text-Inhalt als auch das gesamte visuelle Layout, um zu entscheiden, wo die Seite in den Suchergebnissen erscheinen kann. Je besser eine Suchmaschine eine Website verstehen kann, desto besser wird diese zu Begriffen zugeordnet, nach denen Menschen suchen.

Nachdem eine Seite entdeckt wurde, versucht die Suchmaschine zu verstehen, worum es auf der Seite geht. Dieser Vorgang wird als Indizierung bezeichnet. Moderne Suchmaschinen analysieren den Inhalt der Seite, katalogisieren die auf der Seite eingebetteten Bilder und Videodateien und versuchen auch sonst, die Seite zu verstehen. Diese Informationen werden im Suchmaschinen-Index gespeichert, einer riesigen Datenbank, die auf vielen Computern gespeichert ist.

Anschließend analysieren komplexe Programme die abgelegten Daten jeder Webseite, aber auch Daten von anderen Webseiten über jede Webseite, um jede Website einzeln zu bewerten und festzulegen, ob und wie hoch oder niedrig die Seiten der Website bei verschiedenen Suchanfragen erscheinen werden. Diese Algorithmen können sehr kompliziert sein. Google allein verwendet nach eigenen Angaben mehr als 200 verschiedene Variablen und die Suchmaschinen hüten ihre Algorithmen als Geschäftsgeheimnisse.

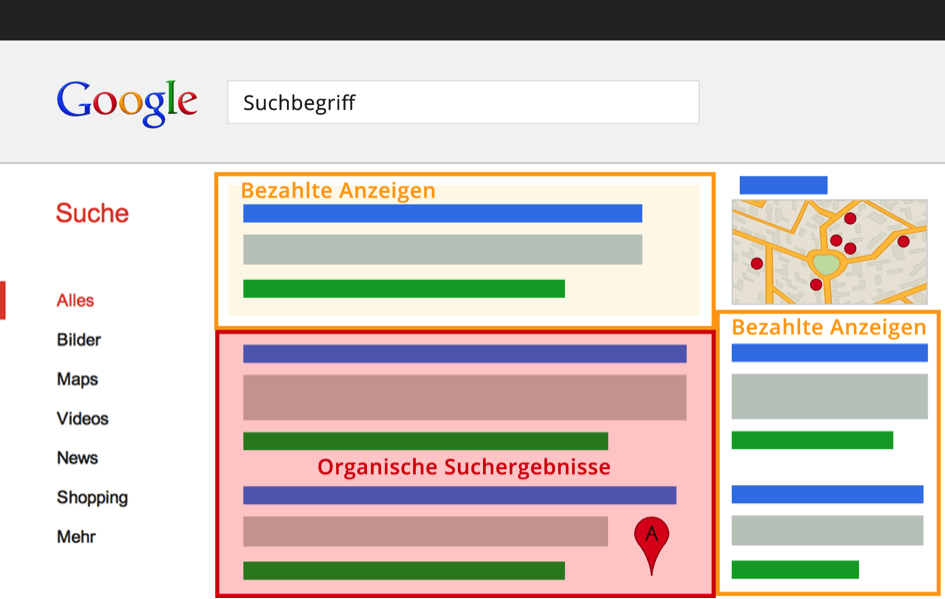

Wenn ein Nutzer eine Suchanfrage eingibt, versucht eine Suchmaschine, die relevanteste Antwort aus ihrem Index zu finden, wobei je nach Suchanfrage unterschiedlich viele Faktoren berücksichtigt werden. Die Suchmaschine versucht stets, die qualitativ hochwertigsten Antworten zu ermitteln und andere Faktoren zu berücksichtigen, die das beste Nutzererlebnis und die passendste Antwort bieten, indem Dinge wie der Standort des Nutzers, die Sprache und das Gerät (Desktop oder Telefon) berücksichtigt werden. So würde zum Beispiel die Suche nach „Fahrradwerkstätten“ einem Nutzer in München andere Ergebnisse liefern als einem Nutzer in Hamburg.

Übrigens: Die meisten Suchmaschinen, allen voran natürlich Google und bing akzeptieren keine Zahlungen, um Seiten höher zu platzieren! Die Platzierung jeder Seite erfolgt vollkommen automatisiert und programmatisch und kann nicht durch Menschen direkt beeinflusst werden.

Willst Du mehr darüber wissen, wie die Web-Suche funktioniert?

Abonniere das kostenlose KI-Update

Bleib auf dem Laufenden in Sachen Künstliche Intelligenz!

Melde Dich jetzt mit Deiner E-Mail-Adresse an und ich versorge Dich kostenlos mit News-Updates, Tools, Tipps und Empfehlungen aus den Bereichen Künstliche Intelligenz für dein Online Business, WordPress, SEO, Online-Marketing und vieles mehr.

Keine Sorge, ich mag Spam genauso wenig wie Du und gebe Deine Daten niemals weiter! Du bekommst höchstens einmal pro Woche eine E-Mail von mir. Versprochen.