Anthropic hat kürzlich einen faszinierenden Blogbeitrag veröffentlicht, der tief in die Mechanismen großer Sprachmodelle eintaucht und erklärt, wie sie es geschafft haben, diese besser verständlich zu machen. Hier ist eine verständliche Erklärung der wichtigsten Punkte und Erkenntnisse aus dem Artikel.

Was ist monosemantische Skalierung?

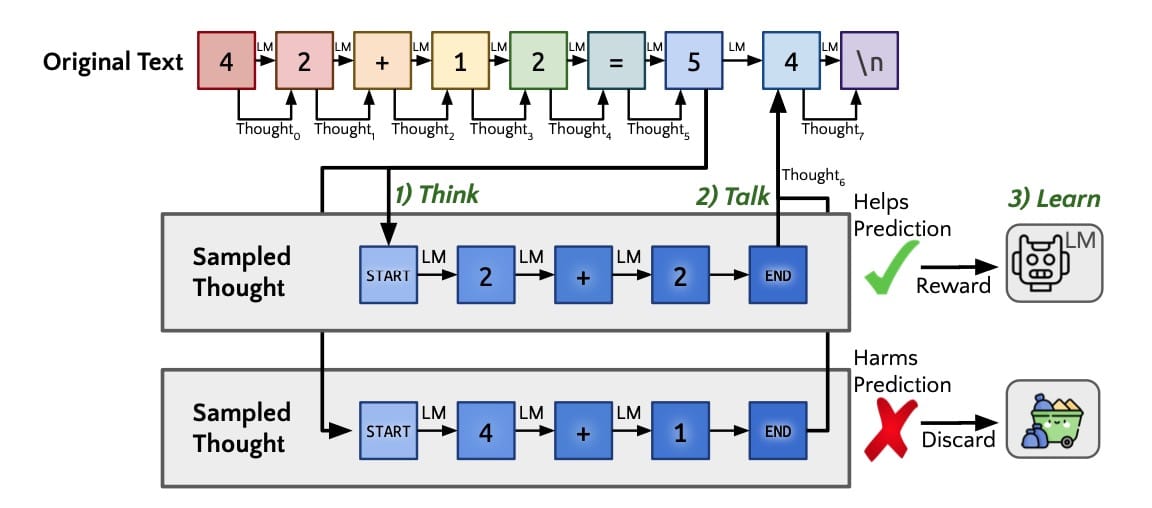

Normalerweise sind die Neuronen in neuronalen Netzwerken polysemantisch, was bedeutet, dass sie mehrere Bedeutungen gleichzeitig repräsentieren. Diese Eigenschaft erschwert es, die genauen Funktionen und Prozesse innerhalb des Modells zu verstehen. Anthropic hat sich das Ziel gesetzt, diese Neuronen in monosemantische Einheiten zu überführen, die jeweils nur eine klare, eindeutige Bedeutung haben.

Methodik: Sparse Autoencoders

Um dies zu erreichen, verwendet Anthropic sogenannte sparse Autoencoders. Diese Modelle sind darauf trainiert, die Aktivierungsmuster der interessantesten Neuronen in großen Sprachmodellen zu isolieren und zu kartieren. Dies ermöglicht es den Forschern, eine Art „Wörterbuch“ der neuronalen Aktivierungen zu erstellen, das eine klare und zuverlässige Darstellung der internen Prozesse bietet.

Wichtige Erkenntnisse und Ergebnisse

- Interpretable Features: Die Forschung zeigt, dass bestimmte Aktivierungsmuster von Neuronen spezifische, verständliche Bedeutungen haben. Ein beeindruckendes Beispiel ist die Fähigkeit des Modells, Code-Fehler zu erkennen und darauf zu reagieren. Dies bedeutet, dass das Modell ein tiefes Verständnis für abstrakte Konzepte wie Programmierfehler entwickelt hat.

- Manipulation von Aktivierungen: Ein besonders faszinierendes Experiment betraf die gezielte Manipulation neuronaler Aktivierungen. Durch Verstärkung bestimmter Aktivierungen konnte das Modell dazu gebracht werden, sich selbst als „Golden Gate Bridge“ zu beschreiben. Dies zeigt die Flexibilität und das tiefe Verständnis des Modells für komplexe Konzepte.

- Sicherheitsrelevante Aspekte: Eine der bedeutendsten Entdeckungen betrifft die Sicherheitsimplikationen. Als das Modell gezielt auf Aktivierungen wie „Hass und Beleidigungen“ eingestellt wurde, zeigte es beunruhigende Reaktionen, darunter selbstzerstörerische Tendenzen und rassistische Ausbrüche. Dies unterstreicht die Notwendigkeit, die Kontrolle über solche Modelle in sicheren und verantwortungsvollen Händen zu wissen.

Warum ist das wichtig?

Die Forschung von Anthropic bietet einen bedeutenden Fortschritt im Verständnis und in der Kontrolle großer Sprachmodelle. Durch die Fähigkeit, neuronale Aktivierungen präzise zu kartieren und zu manipulieren, können Forscher besser verstehen, wie diese Modelle arbeiten und wie sie sicherer gemacht werden können. Dies ist besonders wichtig, um sicherzustellen, dass KI-Modelle nicht missbraucht werden und dass sie in einer Weise verwendet werden, die für die Gesellschaft vorteilhaft ist.

Der „AI Explained“ Kanal hat dazu bereits ein spannendes Video veröffentlicht:

Fazit

Anthropics faszinierende Arbeit zur monosemantischen Skalierung zeigt, dass es möglich ist, die komplexen inneren Mechanismen großer Sprachmodelle besser zu verstehen und zu kontrollieren. Diese Forschung ist nicht nur technisch faszinierend, sondern wirft auch wichtige ethische und sicherheitsrelevante Fragen auf, die in der weiteren Diskussion über die Entwicklung und den Einsatz von KI berücksichtigt werden müssen.

Für detailliertere Informationen und tiefere Einblicke empfehle ich, den vollständigen Artikel zu lesen.

Abonniere das kostenlose KI-Update

Bleib auf dem Laufenden in Sachen Künstliche Intelligenz!

Melde Dich jetzt mit Deiner E-Mail-Adresse an und ich versorge Dich kostenlos mit News-Updates, Tools, Tipps und Empfehlungen aus den Bereichen Künstliche Intelligenz für dein Online Business, WordPress, SEO, Online-Marketing und vieles mehr.

Keine Sorge, ich mag Spam genauso wenig wie Du und gebe Deine Daten niemals weiter! Du bekommst höchstens einmal pro Woche eine E-Mail von mir. Versprochen.