Ian P. McCarthy, Timothy R. Hannigan und André Spicer haben sich in einem sehr guten Artikel im Harvard Business Review dem Thema Halluzinationen von Chatbots und großen Sprachmodellen angenommen und das Ganze mal aus Sicht des Risikomanagements von Unternehmen bewertet.

Sie verwenden für ungenaue und unwahre Inhalte von Chatbots, die von Menschen unkritisch für Aufgaben verwendet werden den Begriff „Botshit“ und machen zu Recht darauf aufmerksam, dass dieser erhebliche Risiken für Unternehmen darstellen kann. Dazu gehören Reputationsschäden, Fehlentscheidungen, rechtliche Haftung, wirtschaftliche Verluste und sogar Gefährdung der menschlichen Sicherheit.

Auf absehbare Zeit ist es unwahrscheinlich, dass Chatbots verschwinden werden und auch wenn RAG und Grounding-Techniken die Assistenten zuverlässiger machen und die KI-Forscherinnen und -Forscher mit Hochdruck an zuverlässigeren Modellen arbeitet, müssen wir uns die Frage stellen, wie Unternehmen diese Risiken managen und gleichzeitig die Vorteile dieser vielversprechenden neuen Werkzeuge nutzen können.

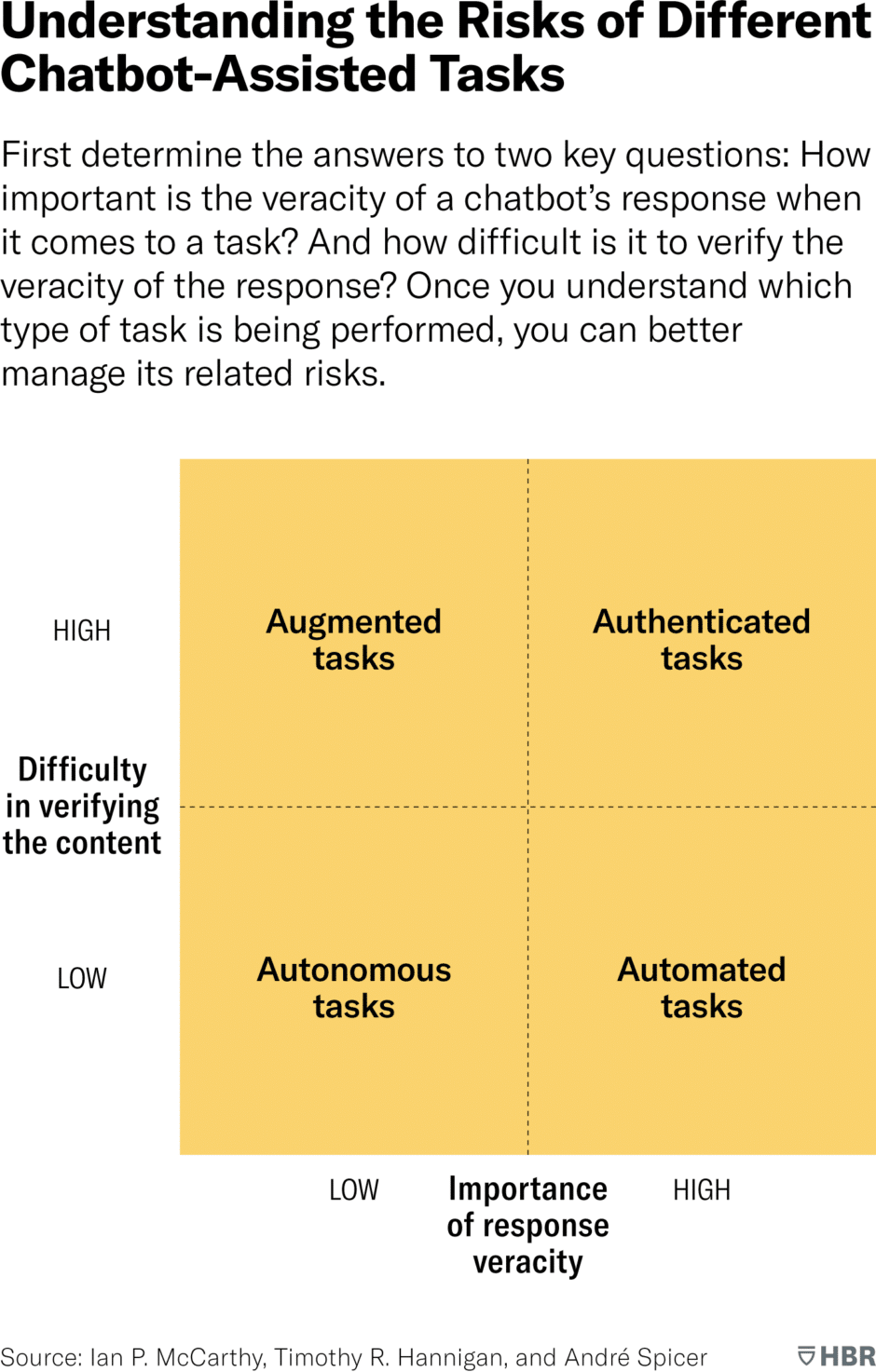

Die Autoren schlagen vor, basierend auf ihrer Forschung zwei Schlüsselfragen zu stellen:

- Wie wichtig ist die Richtigkeit der Chatbot-Antwort für eine bestimmte Aufgabe?

- Wie schwierig ist es, die Richtigkeit der Chatbot-Antwort zu überprüfen?

Anhand der Antworten auf diese Fragen können Unternehmen die mit einer bestimmten Aufgabe verbundenen Risiken besser identifizieren und erfolgreich mindern.

Die Autoren erläutern verschiedene Vorfälle, bei denen der unkritische Einsatz von Chatbots zu Problemen geführt hat. Zum Beispiel führte ein Fehler des Google-Chatbots Bard zu einem massiven Kurssturz der Alphabet-Aktie. In einem anderen Fall wurden zwei Anwälte mit Geldstrafen belegt, weil sie von ChatGPT generierte fiktive Rechtsfälle eingereicht hatten.

Um die Risiken von „Botshit“ zu managen, schlagen die Autoren vier Kategorien von Aufgaben vor, bei denen Chatbots eingesetzt werden können:

- Authentifizierte Aufgaben: Hier ist die Richtigkeit entscheidend, aber schwer zu überprüfen. Das größte Risiko ist eine falsche Kalibrierung. Dies kann durch sorgfältige Überprüfung und Kalibrierung des Chatbot-Modells gemindert werden.

- Erweiterte Aufgaben: Die Genauigkeit ist weniger wichtig und schwer zu überprüfen. Das Hauptrisiko ist Unwissenheit. Dies kann durch den Einsatz menschlicher Experten zur Ergänzung der Chatbot-Antworten gemindert werden.

- Automatisierte Aufgaben: Genauigkeit ist wichtig und leicht zu überprüfen. Das Risiko liegt in der übermäßigen Routinisierung. Dies kann durch regelmäßige menschliche Überprüfung gemindert werden.

- Autonome Aufgaben: Genauigkeit ist weniger wichtig und leicht zu überprüfen. Das Risiko besteht in einer „Black Box“. Dies kann durch Einschränkung des Einsatzbereichs und strenge Leitplanken gemindert werden.

Zusammenfassend lässt sich sagen, dass Chatbots und andere KI-Werkzeuge ein großes Potenzial haben, viele Arbeitsprozesse erheblich zu verbessern. Wie bei jeder wichtigen neuen Technologie bringen sie jedoch auch Risiken mit sich. Bei sorgfältigem Management können diese Risiken eingedämmt werden, während gleichzeitig die Vorteile genutzt werden können.

Ich finde den Artikel sehr lesenswert, insbesondere weil die Autoren nicht so tun, als ließen sich Halluzinationen technisch lösen oder ignorieren, sondern liefern für unterschiedliche Aufgaben differenzierte Ansätze für eine Mitigierung der Risiken.

Abonniere das kostenlose KI-Update

Bleib auf dem Laufenden in Sachen Künstliche Intelligenz!

Melde Dich jetzt mit Deiner E-Mail-Adresse an und ich versorge Dich kostenlos mit News-Updates, Tools, Tipps und Empfehlungen aus den Bereichen Künstliche Intelligenz für dein Online Business, WordPress, SEO, Online-Marketing und vieles mehr.

Keine Sorge, ich mag Spam genauso wenig wie Du und gebe Deine Daten niemals weiter! Du bekommst höchstens einmal pro Woche eine E-Mail von mir. Versprochen.